Skywork UniPic开源!从零预训练打造生图、理解和编辑一体化模型

此外,Skywork-UniPic 完成端到端优化流程,能够实现生成、理解、编辑三大能力的协同训练和相互促进,突破传统方法中能力权衡的技术瓶颈。

这一架构设计不仅保持了自回归模型的简洁高效,更通过共享编码器实现了跨任务的深度协同,为多模态统一模型的实用化部署奠定了坚实基础。

用户只需要输入提示词,Skywork-UniPic 既可以像 VLM 一样理解图像、像 T2I 模型一样生成图片,还可以像美图工具一样,一键实现风格转绘/吉卜力化的编辑功能。

02

模型优势:1.5B 轻量级规模性能逼近同类大参数统一模型,诠释了“小而美”的技术美学

团队在追求模型能力极限的同时,也坚持效率重要性的设计理念。Skywork UniPic 以 1.5B 的紧凑参数规模,真正诠释了“小而美”的技术美学:

多重技术亮点

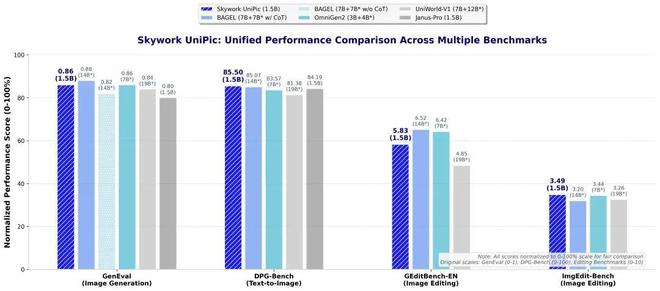

指令遵循能力媲美大型模型:在 GenEval 指令遵循评估中取得 0.86 的优异成绩,超越了绝大多数同类统一模型,在无 CoT 的情况下取得了 SOTA 分数,逼近较大模型 BAGEL(7B+7B*)带 CoT 的 0.88 分;

复杂指令生图能力领先:在 DPG-Bench 复杂指令生图基准上达到 85.5 分的行业 SOTA 水平;

图像编辑能力统一模型第一梯队:GEditBench-EN 获得 5.83 分,ImgEdit-Bench 达到3.49分,展现出精准的编辑执行能力;

参数效率优势显著:相比同类大参数统一模型(如 BAGEL 的 14B 总参数、UniWorld-V1 的 19B 总参数),Skywork UniPic 以 1.5B 的轻量级规模实现了接近甚至超越大参数模型的性能表现;

部署友好,真正可落地:模型在 RTX 4090 消费级显卡上均可流畅运行,为广大开发者和研究者提供了真正可落,地的统一模型解决方案,大幅降低了技术应用门槛。

03

Skywork-UniPic是怎样炼成的?

数据构建:亿级高质量语料库支撑统一模型预训练

首先,Skywork UniPic 的卓越性能,并非源自数据堆叠的蛮力,而是得益于一套高度精炼、系统优化的数据构建体系。

团队突破了“更大即更强”的传统认知边界,通过约亿级规模的精选预训练语料与数百万级任务精调(SFT)样本,成功构建出一套面向理解、生成与编辑三大核心任务的高效能多模态训练语料库。

这一构建体系产生的语料库不仅显著压缩了训练资源成本,更在模型泛化能力与任务迁移表现上展现出惊人的性价比,充分验证了小规模、精筛选、高质量数据对统一多模态模型训练的可行性与潜力。

奖励模型构建:数据质量驱动的智能评估体系

其次,为了确保 Skywork UniPic 在图像生成和编辑任务上的卓越表现,我们设计了专用于图像生成的Reward Model(Skywork-ImgReward)和专用于图片编辑的Reward Model (Skywork-EditReward)。

其中,Skywork-ImgReward是基于强化学习训练的Reward Model,相比于其他T2I Reward Model,Skywork-ImgReward在多个文生图场景下的偏好选择表现都更接近人类偏好。它不仅被用来作为文生图数据质量的筛选,也可以在后续被用于图像生成能力强化学习训练中的奖励信号,以及作为生成图像的质量评估指标。

同时面对图像编辑这一核心挑战,我们创新性地构建了具有针对性的Skywork-EditReward,其被用作数据质量评估时可以自动剔除超过30%的低质量编辑样本,在 GEditBench-EN 和 ImgEdit-Bench 基准测试中表现明显改善。后续同样也可以被用作图像编辑强化学习训练中的奖励信号,以及作为图像编辑的质量评估指标。

训练体系优化与策略提升

MAR训练优化体系:为提升模型表现,我们采用了两项关键优化策略:首先,在数据层面引入覆盖更广视觉场景和类别的亿级专有图像数据,显著拓展了模型的学习空间。其次,训练过程中采用渐进式分辨率提升策略,先在256×256分辨率下建立稳定的底层特征抽取能力,再逐步迁移至512×512,以增强模型的语义理解和细粒度建模能力。

HARMON训练优化体系:为进一步提升模型性能并兼顾训练效率,我们设计了多阶段分层分辨率训练机制。在第一阶段,模型在512×512分辨率下进行微调,聚焦基础特征提取的稳定性与收敛性。随后逐步提升输入分辨率至1024×1024,促使模型更好地捕捉纹理、边缘等高精度细节信息。

同时,我们采用分阶段参数解冻策略,逐步释放模型能力。在初始阶段,仅训练Projector模块以实现视觉与语言特征的对齐,冻结主干网络和LLM参数;接着在保持LLM编码器冻结的前提下优化视觉主干;最后进入全量解冻阶段,进行端到端联合优化,实现多模态协同增强。

渐进式多任务训练策略:为解决理解、生成和编辑三类任务难以兼得的问题,我们提出渐进式多任务训练机制。

训练初期,模型先专注于单一任务(如文本生成图像),待其收敛后再引入理解与编辑任务,按照由易到难的顺序逐步增加任务复杂度,避免多任务早期相互干扰。在精细化阶段,我们通过奖励模型筛选构建高质量训练数据,采用动态阈值与多样性采样策略,确保样本既具高置信度又具语义多样性。

整体来看,以上策略在训练过程中实现了结构合理的能力释放和任务适应,显著提升了模型在理解、生成和编辑等任务上的统一表现,达成真正意义上的“一专多能”。

过去半年,昆仑万维已经开源了多个SOTA大模型,涵盖奖励模型、推理、软件工程、多模态、空间智能等领域。今天,Skywork-UniPic 正式加入「Skywork」开源大家庭,让AI真正成为每个人触手可及的创意伙伴。

昆仑万维开源系列

更多 Skywork 系列开源模型,可在网站查看。

相关文章

从AGI到ASI,阿里云还想做什么?

在阿里云看来,未来的商业竞争,本质上是技术生态的竞争。谁能掌握最底层的、最核心的智能技术,谁能构建最繁荣的开发者和应用生态,谁就能在智能时代获得最宽广的“护城河”。 时至今日,生成式AI的浪潮之巅已...

19岁辍学创业的华裔天才,获扎克伯格150亿美元投资!财富已达20亿美元!

6月13日,人工智能创企Scale AI宣布获得Meta Platforms重大新投资,公司估值超过290亿美元(约合人民币2085亿元)。该协议还将大幅拓展Scale和Meta的商业合作关系,以加速...

科大讯飞刘庆峰出现在重大场合,登上《新闻联播》

7月24日下午,国务院总理李强在北京人民大会堂同欧盟委员会主席冯德莱恩共同出席中欧企业家座谈会。 当日晚间播出的《新闻联播》画面显示,包括刘庆峰在内的多位中方民营企业家参加了座谈会,而刘庆峰是唯一一...

美媒:没有美国芯片,中企也能蓬勃发展

彭博社9月26日文章,原题:中国科技企业表明不需要英伟达芯片也能蓬勃发展 大家好,我现在来到合肥,这座知名度相对较低的城市位于上海以西,当地科技企业正在告别英伟达产品,转而与华为组成合作伙伴。本周,我...

黄仁勋:任何轻视华为、轻视中国制造能力的人,都极其天真!

7月16日下午3点20分许,英伟达创始人、CEO黄仁勋出现在北京前门区域,《每日经济新闻》记者在现场注意到,黄仁勋脱下了上午的唐装,又换上了标志性的皮衣。随后,黄仁勋出席媒体见面会并回答提问。 在英...

中美贸易战关键时刻,这家浙江企业的美国组件工厂宣布正式投产!

明知山有虎,偏向虎山行。这或许就是在这一轮经济周期中,浙商敢于冒险、敢于挑战、敢于胜利的关键所在! 4月24日,博威合金在美国的2GW组件工厂正式投产。该工厂主要将生产Boviet的Gamma系列单...

豫ICP备2024079567号-1

豫ICP备2024079567号-1